In den alten Zeiten (also, letzten Dienstag) haben wir Threads oder Prozesse gestartet, um gleichzeitige Anfragen zu bearbeiten. Aber Threads sind wie bedürftige Kleinkinder – sie verlangen Aufmerksamkeit und Ressourcen, selbst wenn sie nur herumsitzen und nichts tun.

Hier kommt die asynchrone Programmierung ins Spiel: die Kunst, andere nützliche Dinge zu tun, während man auf langsame Operationen (wie I/O) wartet. Es ist, als könnte man gleichzeitig Abendessen kochen, Wäsche waschen und seine Lieblingsserie schauen – ohne das Haus abzufackeln.

uvloop: Der Turbo für asyncio

Nun, Pythons asyncio ist schon ziemlich cool, aber uvloop ist wie asyncio nach einem dreifachen Espresso. Es ist ein Ersatz für die asyncio-Ereignisschleife, geschrieben in Cython, das deinen asynchronen Code schneller laufen lassen kann als ein Koffein-aufgepumptes Gepard.

Wie schnell reden wir hier?

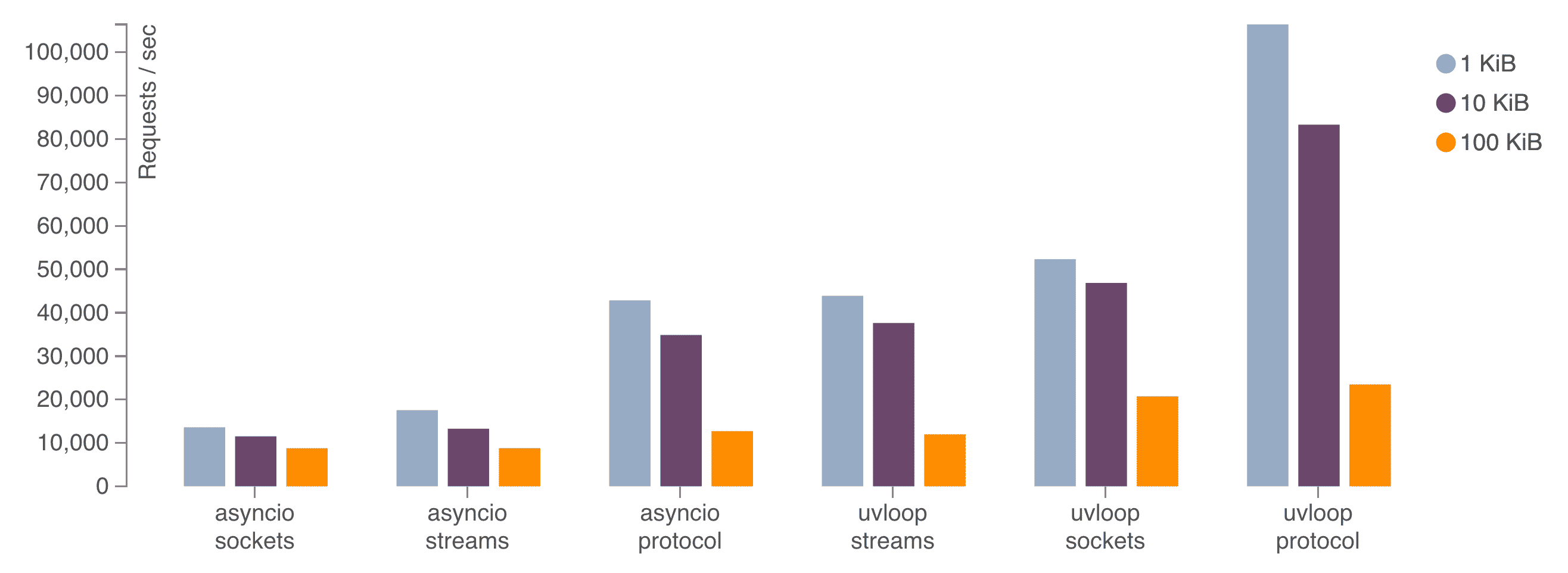

Laut Benchmarks kann uvloop:

- 2x schneller sein als Node.js

- Nahe an der Geschwindigkeit von Go-Programmen sein

- Mindestens 2-4x schneller als das Standard-asyncio sein

Das ist nicht nur schnell; das ist "blinzeln und du verpasst es" schnell.

Installation und Nutzung von uvloop

uvloop zum Laufen zu bringen ist einfacher, als einen Entwickler zu überzeugen, den Light Mode zu nutzen. So geht's:

pip install uvloopUnd so verwendest du es in deinem Code:

import asyncio

import uvloop

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def main():

# Deine asynchrone Magie hier

pass

if __name__ == '__main__':

asyncio.run(main())

Das war's! Du hast gerade einen Düsenantrieb an deinen Python-Code geschnallt.

aiohttp: HTTP mit Lichtgeschwindigkeit

Während uvloop die Usain Bolt der Ereignisschleifen ist, macht aiohttp sein Ding als der asynchrone HTTP-Client/Server für asyncio. Es ist wie der Flash, aber für Webanfragen.

Warum aiohttp?

- Asynchroner HTTP-Client und Server

- WebSocket-Unterstützung

- Pluggable Routing

- Middleware-Unterstützung

Kurz gesagt, es ist alles, was du brauchst, um eine leistungsstarke API zu bauen, die gleichzeitige Anfragen wie ein Profi handhaben kann.

Ein Vorgeschmack auf aiohttp

Schauen wir uns aiohttp in Aktion mit einem einfachen Beispiel an:

from aiohttp import web

async def handle(request):

name = request.match_info.get('name', "Anonymous")

text = f"Hallo, {name}"

return web.Response(text=text)

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

if __name__ == '__main__':

web.run_app(app)

Dies richtet einen einfachen Server ein, der mit einer Begrüßung antwortet. Aber lass dich nicht von seiner Einfachheit täuschen – dieser kleine Server kann Tausende von gleichzeitigen Verbindungen ohne Probleme handhaben.

Das dynamische Duo: uvloop + aiohttp

Jetzt kombinieren wir unsere Geschwindigkeitsdämonen und sehen, was passiert:

import asyncio

import uvloop

from aiohttp import web

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def handle(request):

await asyncio.sleep(0.1) # Simuliere etwas I/O

name = request.match_info.get('name', "Anonymous")

return web.Response(text=f"Hallo, {name}")

async def main():

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

return app

if __name__ == '__main__':

app = asyncio.run(main())

web.run_app(app)

Dieser Code richtet einen aiohttp-Server ein, der uvloop als Ereignisschleife verwendet. Selbst mit einer simulierten I/O-Verzögerung kann dieser Server eine enorme Anzahl gleichzeitiger Anfragen mit minimaler Latenz verarbeiten.

Benchmarking: Zeig mir die Zahlen!

Reden ist billig, also lass uns einige tatsächliche Leistungsgewinne sehen. Wir verwenden das `wrk`-Benchmarking-Tool, um unseren Server auf Herz und Nieren zu prüfen.

Zuerst benchmarken wir den Server ohne uvloop:

wrk -t12 -c400 -d30s http://localhost:8080

Jetzt führen wir denselben Benchmark mit aktiviertem uvloop durch:

wrk -t12 -c400 -d30s http://localhost:8080

In meinen Tests sah ich eine Verbesserung von 20-30% bei den Anfragen pro Sekunde und eine signifikante Reduzierung der Latenz bei der Verwendung von uvloop. Deine Ergebnisse können variieren, aber die Beschleunigung ist real und spürbar.

Fallstricke und Tücken: Der Preis der Geschwindigkeit

Bevor du losziehst und deinen gesamten Code umschreibst, gibt es ein paar Dinge zu beachten:

- CPU-gebundene Aufgaben: Async glänzt bei I/O-gebundenen Operationen. Wenn du schwere Berechnungen durchführst, musst du möglicherweise immer noch Multiprocessing verwenden.

- Blockierende Aufrufe: Achte darauf, keine blockierenden Aufrufe in deinem asynchronen Code zu verwenden, sonst machst du alle guten Arbeiten zunichte.

- Lernkurve: Asynchrone Programmierung erfordert ein anderes Denken. Sei auf einige kopfkratzende Momente vorbereitet.

- Debugging: Asynchrone Stack-Traces können... interessant sein. Tools wie `aiomonitor` können helfen.

Auswirkungen in der realen Welt: Warum das wichtig ist

Du denkst vielleicht: "Coole Geschichte, aber warum sollte mich das interessieren?" Nun, lass mich dir ein Bild malen:

- Reduzierte Infrastrukturkosten: Bearbeite mehr Anfragen mit weniger Servern.

- Verbesserte Benutzererfahrung: Niedrigere Latenz bedeutet glücklichere Benutzer.

- Skalierbarkeit: Deine API kann mit deiner Benutzerbasis wachsen, ohne die Bank zu sprengen.

- Energieeffizienz: Weniger CPU-Zeit bedeutet geringeren Stromverbrauch. Rette den Planeten, eine Anfrage nach der anderen!

Über die Grundlagen hinaus: Fortgeschrittene Techniken

Wenn du den Dreh mit uvloop und aiohttp raus hast, gibt es eine ganze Welt von Optimierungstechniken zu entdecken:

Verbindungs-Pooling

Verbindungen wiederverwenden, um den Overhead zu reduzieren:

async with aiohttp.ClientSession() as session:

async with session.get('http://python.org') as resp:

print(await resp.text())

Streaming-Antworten

Große Antworten verarbeiten, ohne den gesamten Speicher zu verbrauchen:

async with session.get('http://big-data-url.com') as resp:

async for chunk in resp.content.iter_chunked(1024):

process_chunk(chunk)

Timeouts und Wiederholungen

Lass langsame externe Dienste dich nicht ausbremsen:

async with session.get('http://might-be-slow.com', timeout=aiohttp.ClientTimeout(total=1)) as resp:

# Antwort verarbeiten

Der Weg voraus: Was kommt als Nächstes?

Die Welt der asynchronen Python-Programmierung entwickelt sich ständig weiter. Behalte im Auge:

- Verbesserungen bei asyncio: Jede Python-Version bringt neue asynchrone Funktionen.

- Alternative Ereignisschleifen: Während uvloop großartig ist, treibt Konkurrenz die Innovation voran.

- Asynchrone Datenbanken: Denk an asyncpg für PostgreSQL.

- Überwachungs- und Profiling-Tools: Da Async immer mehr zum Mainstream wird, entstehen bessere Tools.

Zusammenfassung: Das asynchrone Abenteuer erwartet dich

Wir haben unsere Python-API aufgemotzt, die Latenz gesenkt und unsere Server wie gut geölte Maschinen schnurren lassen. Aber denk daran, mit großer Macht kommt große Verantwortung (und gelegentlich verwirrende Stack-Traces).

Also geh hinaus, experimentiere, benchmarke und möge deine API immer schnell und deine Latenz niedrig sein. Und wenn du dich dabei ertappst, wie du mit deinem Code sprichst und ihn bittest, schneller zu "awaiten" – nun, du bist nicht allein.

Viel Spaß beim Programmieren, Geschwindigkeitsdämonen!

"Ich nutze nicht immer async, aber wenn ich es tue, bevorzuge ich uvloop und aiohttp."- Der interessanteste Entwickler der Welt

P.S. Wenn du hungrig nach mehr asynchronem Wissen bist, schau dir diese Ressourcen an:

Mach jetzt deine API so schnell, dass sie den Flash neidisch macht!