Die Herausforderung: Synchronisation ohne Chaos

Objekte über mehrere S3-Buckets in verschiedenen Regionen zu synchronisieren, ist wie das Hüten von Katzen – wenn diese Katzen aus Daten bestehen und sich vermehren, sobald man nicht hinschaut. Die Hauptprobleme, mit denen wir konfrontiert sind, sind:

- Gleichzeitige Aktualisierungen aus verschiedenen Regionen

- Netzwerkpartitionen, die vorübergehende Isolation verursachen

- Versionsunterschiede zwischen Buckets

- Das Bedürfnis nach letztendlicher Konsistenz, ohne die Verfügbarkeit zu opfern

Traditionelle Sperrmechanismen oder zentrale Koordinatoren? Die sind hier so nützlich wie ein Schokoladenteekessel in der Sahara. Wir brauchen etwas... ereignisreicheres.

CRDTs: Die Friedensstifter verteilter Systeme

Konfliktfreie replizierte Datentypen (CRDTs) sind die stillen Helden verteilter Systeme. Sie sind Datenstrukturen, die über mehrere Computer in einem Netzwerk repliziert werden können, wobei die Replikate unabhängig und gleichzeitig ohne Koordination aktualisiert werden können und es immer mathematisch möglich ist, auftretende Inkonsistenzen zu lösen.

Für unseren S3-Replikator verwenden wir einen speziellen Typ von CRDT, einen Grow-Only Counter (G-Counter). Er ist perfekt, um Versionsunterschiede zu handhaben, da er nur Erhöhungen zulässt, niemals Verringerungen. Es ist wie eine Einbahnstraße für die Versionsnummern Ihrer Daten.

Implementierung eines G-Counters

Hier ist eine einfache Implementierung eines G-Counters in Python:

class GCounter:

def __init__(self):

self.counters = {}

def increment(self, node_id):

if node_id not in self.counters:

self.counters[node_id] = 0

self.counters[node_id] += 1

def merge(self, other):

for node_id, count in other.counters.items():

if node_id not in self.counters or self.counters[node_id] < count:

self.counters[node_id] = count

def value(self):

return sum(self.counters.values())

Dieser G-Counter erlaubt es jedem Knoten (in unserem Fall jedem S3-Bucket), seinen eigenen Zähler unabhängig zu erhöhen. Wenn es Zeit ist zu synchronisieren, führen wir einfach die Zähler zusammen und nehmen den Maximalwert für jeden Knoten.

Lambda@Edge: Ihr verteilter Wachhund

Jetzt, da wir unseren CRDT haben, brauchen wir eine Möglichkeit, Änderungen über unsere S3-Buckets zu verbreiten. Hier kommt Lambda@Edge ins Spiel, AWS's Lösung, um Ihre Lambda-Funktionen weltweit an AWS Edge-Standorten auszuführen. Es ist wie ein kleiner, effizienter Roboter an jeder Ecke der Welt, bereit, in Aktion zu treten.

Wir werden Lambda@Edge verwenden, um:

- Änderungen in einem unserer S3-Buckets zu erkennen

- Den lokalen G-Counter zu aktualisieren

- Die Änderungen an andere Buckets zu verbreiten

- G-Counter von verschiedenen Buckets zusammenzuführen

Einrichten von Lambda@Edge

Erstellen wir zunächst eine Lambda-Funktion, die bei der Erstellung oder Aktualisierung eines S3-Objekts ausgelöst wird:

import boto3

import json

from gcounter import GCounter

def lambda_handler(event, context):

# Extrahiere Bucket- und Objektinformationen aus dem Ereignis

bucket = event['Records'][0]['s3']['bucket']['name']

key = event['Records'][0]['s3']['object']['key']

# S3-Client initialisieren

s3 = boto3.client('s3')

# Den aktuellen G-Counter aus den Objektmetadaten lesen

try:

response = s3.head_object(Bucket=bucket, Key=key)

current_counter = json.loads(response['Metadata'].get('g-counter', '{}'))

except:

current_counter = {}

# Einen neuen G-Counter erstellen und mit dem aktuellen zusammenführen

g_counter = GCounter()

g_counter.counters = current_counter

g_counter.increment(bucket)

# Die Objektmetadaten mit dem neuen G-Counter aktualisieren

s3.copy_object(

Bucket=bucket,

CopySource={'Bucket': bucket, 'Key': key},

Key=key,

MetadataDirective='REPLACE',

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

# Änderungen an andere Buckets verbreiten

propagate_changes(bucket, key, g_counter)

def propagate_changes(source_bucket, key, g_counter):

# Liste aller Buckets, die synchronisiert werden sollen

buckets = ['bucket1', 'bucket2', 'bucket3'] # Fügen Sie hier Ihre Bucket-Namen hinzu

s3 = boto3.client('s3')

for target_bucket in buckets:

if target_bucket != source_bucket:

try:

# Das Objekt aus dem Quell-Bucket abrufen

response = s3.get_object(Bucket=source_bucket, Key=key)

# Das Objekt in den Ziel-Bucket kopieren

s3.put_object(

Bucket=target_bucket,

Key=key,

Body=response['Body'].read(),

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

except Exception as e:

print(f"Fehler beim Verbreiten von Änderungen zu {target_bucket}: {str(e)}")

Diese Lambda-Funktion übernimmt die Hauptarbeit beim Aktualisieren des G-Counters und Verbreiten von Änderungen an andere Buckets. Es ist wie ein hyperaktiver Oktopus, der gleichzeitig alle Ihre Buckets erreicht.

Umgang mit Versionsunterschieden

Nun wollen wir das große Problem angehen: Versionsunterschiede. Unser G-Counter kommt hier zur Rettung. Da er nur Erhöhungen zulässt, können wir ihn verwenden, um festzustellen, welche Version eines Objekts die aktuellste über alle Buckets hinweg ist.

So können wir unsere Lambda-Funktion anpassen, um mit Versionskonflikten umzugehen:

def resolve_version_conflict(bucket, key, g_counter):

s3 = boto3.client('s3')

# Alle Versionen des Objekts abrufen

versions = s3.list_object_versions(Bucket=bucket, Prefix=key)['Versions']

# Die Version mit dem höchsten G-Counter-Wert finden

latest_version = max(versions, key=lambda v: GCounter().merge(json.loads(v['Metadata'].get('g-counter', '{}'))))

# Wenn die neueste Version nicht die aktuelle Version ist, aktualisieren

if latest_version['VersionId'] != versions[0]['VersionId']:

s3.copy_object(

Bucket=bucket,

CopySource={'Bucket': bucket, 'Key': key, 'VersionId': latest_version['VersionId']},

Key=key,

MetadataDirective='REPLACE',

Metadata={'g-counter': json.dumps(g_counter.counters)}

)

Diese Funktion überprüft alle Versionen eines Objekts und stellt sicher, dass die Version mit dem höchsten G-Counter-Wert als aktuelle Version festgelegt wird. Es ist wie ein zeitreisender Historiker, der immer sicherstellt, dass die aktuellste Version der Geschichte präsentiert wird.

Das große Ganze: Alles zusammenfügen

Was haben wir hier gebaut? Lassen Sie es uns aufschlüsseln:

- Einen G-Counter CRDT zur Handhabung von Versionierung und Konfliktlösung

- Eine Lambda@Edge-Funktion, die:

- Änderungen in S3-Buckets erkennt

- Den G-Counter aktualisiert

- Änderungen an andere Buckets verbreitet

- Versionskonflikte löst

Dieses System ermöglicht es uns, letztendliche Konsistenz über mehrere S3-Buckets hinweg zu wahren, ohne die Verfügbarkeit zu opfern. Es ist wie ein sich selbst organisierendes, sich selbst heilendes Datenökosystem.

Mögliche Fallstricke und Überlegungen

Bevor Sie dies in der Produktion implementieren, beachten Sie folgende Punkte:

- Lambda@Edge hat einige Einschränkungen, einschließlich Ausführungszeit und Nutzlastgröße. Für große Objekte müssen Sie möglicherweise eine Chunking-Strategie implementieren.

- Diese Lösung geht davon aus, dass Netzwerkpartitionen vorübergehend sind. Bei längeren Partitionen benötigen Sie möglicherweise zusätzliche Abstimmungsmechanismen.

- Der G-Counter wird im Laufe der Zeit wachsen. Für langlebige Objekte mit häufigen Aktualisierungen müssen Sie möglicherweise eine Bereinigungsstrategie implementieren.

- Testen Sie immer gründlich in einer Staging-Umgebung, bevor Sie in die Produktion gehen. Verteilte Systeme können knifflige Biester sein!

Zusammenfassung: Warum sich die Mühe machen?

Sie fragen sich vielleicht: "Warum all diese Mühe? Kann ich nicht einfach die integrierte Replikation von AWS verwenden?" Nun, ja, das könnten Sie. Aber unsere Lösung bietet einige einzigartige Vorteile:

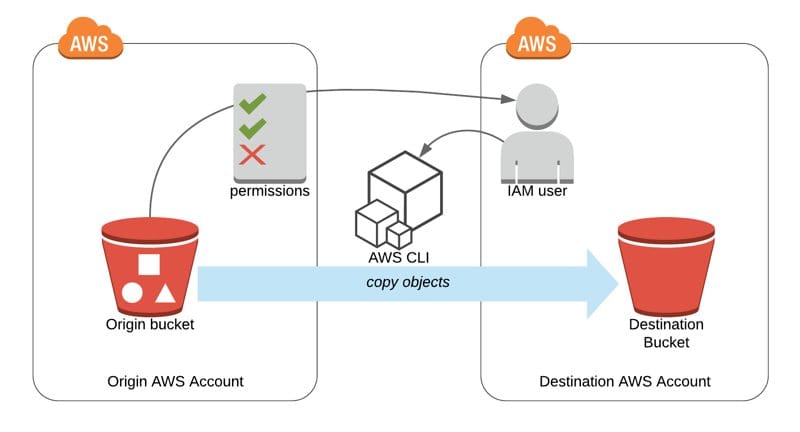

- Sie funktioniert über verschiedene AWS-Konten und Regionen hinweg, nicht nur innerhalb eines einzelnen Kontos.

- Sie bietet stärkere Konsistenzgarantien im Falle von Netzwerkpartitionen und gleichzeitigen Aktualisierungen.

- Sie ist flexibler und kann an spezifische Geschäftslogik oder Datenmodelle angepasst werden.

Am Ende gibt Ihnen dieser Ansatz eine feinere Kontrolle über Ihren Datensynchronisationsprozess. Es ist, als wären Sie der Dirigent eines verteilten Datenorchesters, der sicherstellt, dass jedes Instrument (oder in diesem Fall jeder S3-Bucket) in perfekter Harmonie spielt.

Denkanstöße

Während Sie diese Lösung implementieren, ziehen Sie folgende Fragen in Betracht:

- Wie würden Sie dieses System modifizieren, um Löschungen zu handhaben?

- Könnte dieser Ansatz auf andere AWS-Dienste über S3 hinaus erweitert werden?

- Welche anderen Arten von CRDTs könnten in verteilten Cloud-Architekturen nützlich sein?

Denken Sie daran, dass es in der Welt der verteilten Systeme keine Einheitslösung gibt. Aber mit CRDTs und Lambda@Edge in Ihrem Werkzeugkasten sind Sie gut gerüstet, um selbst die herausforderndsten Datensynchronisationsprobleme zu bewältigen. Gehen Sie nun voran und mögen Ihre Daten immer synchron sein!