Warum maßgeschneiderte Lösungen, wenn es fertige gibt?

- Flexibilität: Passen Sie die Grenzen an Ihre spezifischen Anwendungsfälle und Benutzerstufen an

- Leistung: Optimieren Sie für Ihre Infrastruktur und Verkehrsmuster

- Kontrolle: Feinabstimmung jedes Aspekts, wie Sie den API-Verbrauch verwalten

- Lernen: Gewinnen Sie tiefere Einblicke in das Verhalten und die Nutzungsmuster Ihrer API

Da wir nun auf derselben Seite sind, lassen Sie uns in die Details eintauchen!

Die Bausteine: Rate-Limiting-Algorithmen

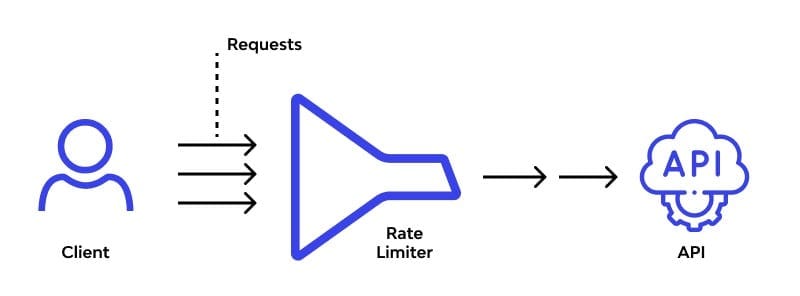

Im Herzen jeder Rate-Limiting-Lösung liegen Algorithmen. Lassen Sie uns einige beliebte erkunden und sehen, wie wir sie implementieren können:

1. Token-Bucket-Algorithmus

Stellen Sie sich einen Eimer vor, der sich mit einer konstanten Rate mit Tokens füllt. Jede API-Anfrage verbraucht ein Token. Ist der Eimer leer, wird die Anfrage abgelehnt. Einfach, aber effektiv!

import time

class TokenBucket:

def __init__(self, capacity, fill_rate):

self.capacity = capacity

self.fill_rate = fill_rate

self.tokens = capacity

self.last_fill = time.time()

def consume(self, tokens):

now = time.time()

time_passed = now - self.last_fill

self.tokens = min(self.capacity, self.tokens + time_passed * self.fill_rate)

self.last_fill = now

if self.tokens >= tokens:

self.tokens -= tokens

return True

return False

# Verwendung

bucket = TokenBucket(capacity=100, fill_rate=10) # 100 Tokens, füllt 10 pro Sekunde auf

if bucket.consume(1):

print("Anfrage erlaubt")

else:

print("Rate-Limit überschritten")

2. Leaky-Bucket-Algorithmus

Denken Sie an einen Eimer mit einem kleinen Loch am Boden. Anfragen füllen den Eimer, und sie "lecken" mit einer konstanten Rate heraus. Wenn der Eimer überläuft, werden eingehende Anfragen abgelehnt.

from collections import deque

import time

class LeakyBucket:

def __init__(self, capacity, leak_rate):

self.capacity = capacity

self.leak_rate = leak_rate

self.bucket = deque()

self.last_leak = time.time()

def add(self):

now = time.time()

self._leak(now)

if len(self.bucket) < self.capacity:

self.bucket.append(now)

return True

return False

def _leak(self, now):

leak_time = (now - self.last_leak) * self.leak_rate

while self.bucket and self.bucket[0] <= now - leak_time:

self.bucket.popleft()

self.last_leak = now

# Verwendung

bucket = LeakyBucket(capacity=5, leak_rate=0.5) # 5 Anfragen, leckt 1 alle 2 Sekunden

if bucket.add():

print("Anfrage erlaubt")

else:

print("Rate-Limit überschritten")

3. Fixed-Window-Counter

Dieser ist einfach: Teilen Sie die Zeit in feste Fenster und zählen Sie die Anfragen in jedem. Setzen Sie den Zähler zurück, wenn ein neues Fenster beginnt.

import time

class FixedWindowCounter:

def __init__(self, window_size, max_requests):

self.window_size = window_size

self.max_requests = max_requests

self.current_window = time.time() // window_size

self.request_count = 0

def allow_request(self):

current_time = time.time()

window = current_time // self.window_size

if window > self.current_window:

self.current_window = window

self.request_count = 0

if self.request_count < self.max_requests:

self.request_count += 1

return True

return False

# Verwendung

counter = FixedWindowCounter(window_size=60, max_requests=100) # 100 Anfragen pro Minute

if counter.allow_request():

print("Anfrage erlaubt")

else:

print("Rate-Limit überschritten")

Implementierung in einem API-Gateway

Da wir nun unsere Algorithmen haben, sehen wir, wie wir sie in ein API-Gateway integrieren können. Wir verwenden FastAPI für dieses Beispiel, aber das Konzept gilt auch für andere Frameworks.

from fastapi import FastAPI, Request, HTTPException

from fastapi.middleware.cors import CORSMiddleware

from TokenBucket import TokenBucket

app = FastAPI()

# CORS-Middleware hinzufügen

app.add_middleware(

CORSMiddleware,

allow_origins=["*"],

allow_credentials=True,

allow_methods=["*"],

allow_headers=["*"],

)

# Erstellen Sie einen Rate-Limiter für jeden Client

rate_limiters = {}

@app.middleware("http")

async def rate_limit_middleware(request: Request, call_next):

client_ip = request.client.host

if client_ip not in rate_limiters:

rate_limiters[client_ip] = TokenBucket(capacity=100, fill_rate=10)

if not rate_limiters[client_ip].consume(1):

raise HTTPException(status_code=429, detail="Rate-Limit überschritten")

response = await call_next(request)

return response

@app.get("/")

async def root():

return {"message": "Hallo, rate-begrenzte Welt!"}

Dieses Setup erstellt einen separaten Rate-Limiter für jede Client-IP, der 100 Anfragen mit einer Auffüllrate von 10 Tokens pro Sekunde erlaubt.

Erweiterte Techniken und Überlegungen

Wenn Sie Ihre benutzerdefinierte Rate-Limiting-Lösung implementieren, beachten Sie diese Punkte:

1. Verteiltes Rate-Limiting

Wenn Ihre API auf mehreren Servern läuft, benötigen Sie eine Möglichkeit, die Rate-Limiting-Daten zu synchronisieren. Erwägen Sie die Verwendung eines verteilten Caches wie Redis:

import redis

class DistributedRateLimiter:

def __init__(self, redis_url, key_prefix, limit, window):

self.redis = redis.from_url(redis_url)

self.key_prefix = key_prefix

self.limit = limit

self.window = window

def is_allowed(self, identifier):

key = f"{self.key_prefix}:{identifier}"

current = self.redis.get(key)

if current is None:

self.redis.set(key, 1, ex=self.window)

return True

elif int(current) < self.limit:

self.redis.incr(key)

return True

return False

# Verwendung

limiter = DistributedRateLimiter("redis://localhost", "api_limit", 100, 60)

if limiter.is_allowed("user123"):

print("Anfrage erlaubt")

else:

print("Rate-Limit überschritten")

2. Dynamisches Rate-Limiting

Passen Sie Ihre Rate-Limits basierend auf der Serverlast oder anderen Metriken an. Dies kann helfen, Überlastungen bei Verkehrsspitzen zu verhindern:

import psutil

def get_dynamic_rate_limit():

cpu_usage = psutil.cpu_percent()

if cpu_usage > 80:

return 50 # Reduzieren Sie das Rate-Limit, wenn die CPU stark ausgelastet ist

elif cpu_usage > 60:

return 75

else:

return 100

# Verwenden Sie dies in Ihrer Rate-Limiting-Logik

dynamic_limit = get_dynamic_rate_limit()

3. Benutzer-spezifische Rate-Limits

Implementieren Sie unterschiedliche Rate-Limits für verschiedene Benutzerstufen oder API-Schlüssel:

def get_user_rate_limit(api_key):

user_tier = database.get_user_tier(api_key)

if user_tier == "premium":

return 1000

elif user_tier == "standard":

return 100

else:

return 10

# Verwenden Sie dies beim Initialisieren von Rate-Limitern

user_limit = get_user_rate_limit(api_key)

rate_limiter = TokenBucket(capacity=user_limit, fill_rate=user_limit/60)

Überwachung und Analyse

Vergessen Sie nicht, die Überwachung für Ihr Rate-Limiting-System zu implementieren. Dies hilft Ihnen, Ihre Algorithmen fein abzustimmen und Probleme frühzeitig zu erkennen.

- Protokollieren Sie Rate-Limit-Treffer und Beinahe-Treffer

- Verfolgen Sie API-Nutzungsmuster

- Richten Sie Alarme für ungewöhnliche Spitzen oder Einbrüche im Verkehr ein

Erwägen Sie die Verwendung von Tools wie Prometheus und Grafana, um Ihre Rate-Limiting-Metriken zu visualisieren:

from prometheus_client import Counter, Histogram

REQUESTS = Counter('api_requests_total', 'Total API requests')

RATE_LIMIT_HITS = Counter('rate_limit_hits_total', 'Total rate limit hits')

LATENCY = Histogram('request_latency_seconds', 'Request latency in seconds')

@app.middleware("http")

async def metrics_middleware(request: Request, call_next):

REQUESTS.inc()

with LATENCY.time():

response = await call_next(request)

if response.status_code == 429:

RATE_LIMIT_HITS.inc()

return response

Fazit: Die Kunst der API-Verkehrskontrolle meistern

Die Implementierung benutzerdefinierter Rate-Limiting-Algorithmen ist wie das Dirigieren einer Symphonie von API-Anfragen. Es erfordert Finesse, ständige Anpassung und ein tiefes Verständnis für den einzigartigen Rhythmus Ihrer API. Aber mit dem richtigen Ansatz können Sie ein harmonisches Gleichgewicht zwischen dem Schutz Ihrer Ressourcen und einer großartigen Benutzererfahrung schaffen.

Denken Sie daran, dass die perfekte Rate-Limiting-Lösung eine ist, die sich mit Ihrer API weiterentwickelt. Scheuen Sie sich nicht, zu experimentieren, Daten zu sammeln und Ihre Algorithmen im Laufe der Zeit zu verfeinern. Ihr zukünftiges Ich (und Ihre Server) werden es Ihnen danken!

"Die Kunst des Rate-Limitings besteht nicht darin, 'nein' zu sagen, sondern 'nicht jetzt' auf die eleganteste Weise zu sagen." - Anonymer API-Guru

Gehen Sie nun hinaus und zähmen Sie dieses API-Verkehrsmonster! Und wenn Sie dieses Biest schon einmal bekämpft haben, teilen Sie Ihre Kriegsgeschichten in den Kommentaren. Schließlich werden die besten Rate-Limiting-Strategien im Feuer der realen Erfahrung geschmiedet.