Willkommen in der Welt der seltenen x86-Op-Codes – die verborgenen Schätze der Befehlssatzarchitektur, die Ihrem Code den entscheidenden Schub geben können, wenn Sie ihn am dringendsten benötigen. Heute tauchen wir tief in die weniger bekannten Ecken moderner Intel- und AMD-CPUs ein, um diese exotischen Anweisungen zu entdecken und zu sehen, wie sie Ihren performancekritischen Code beschleunigen können.

Das vergessene Arsenal

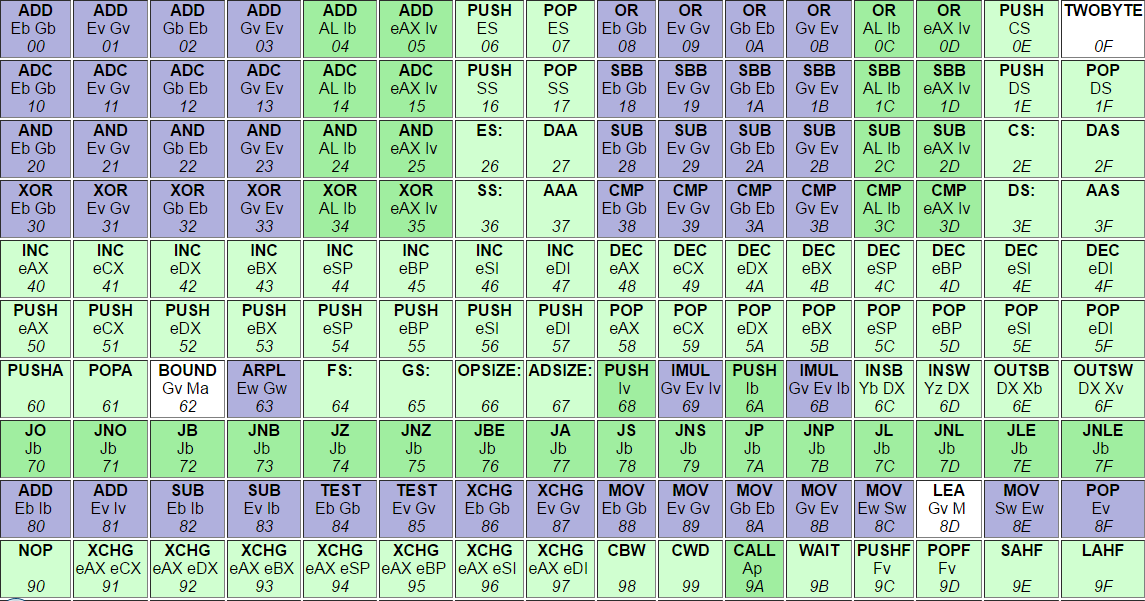

Bevor wir unsere Reise beginnen, lassen Sie uns die Bühne bereiten. Die meisten Entwickler sind mit gängigen x86-Anweisungen wie MOV, ADD und JMP vertraut. Doch unter der Oberfläche verbirgt sich ein Schatz an spezialisierten Op-Codes, die komplexe Operationen in einem einzigen Taktzyklus ausführen können. Diese Anweisungen bleiben oft unbemerkt, weil:

- Sie in einsteigerfreundlichen Ressourcen nicht weit verbreitet dokumentiert sind

- Compiler sie nicht immer automatisch nutzen

- Ihre Anwendungsfälle recht spezifisch sein können

Aber für die Performance-Besessenen unter uns sind diese seltenen Op-Codes wie ein Turbo-Knopf für unseren Code. Lassen Sie uns einige der interessantesten erkunden und sehen, wie sie unser Optimierungsspiel auf ein neues Level heben können.

1. POPCNT: Der Bit-Zähl-Schnellläufer

Als erstes haben wir POPCNT (Population Count), eine Anweisung, die die Anzahl der gesetzten Bits in einem Register zählt. Auch wenn das trivial klingt, ist es eine häufige Operation in Bereichen wie Kryptographie, Fehlerkorrektur und sogar einigen maschinellen Lernalgorithmen.

So könnten Sie traditionell Bits in C++ zählen:

int countBits(uint32_t n) {

int count = 0;

while (n) {

count += n & 1;

n >>= 1;

}

return count;

}Nun sehen wir, wie POPCNT dies vereinfacht:

int countBits(uint32_t n) {

return __builtin_popcount(n); // Wird auf unterstützten CPUs zu POPCNT kompiliert

}Dieser Code ist nicht nur sauberer, sondern auch erheblich schneller. Auf modernen CPUs wird POPCNT in einem einzigen Zyklus für 32-Bit-Integer und in zwei Zyklen für 64-Bit-Integer ausgeführt. Das ist eine enorme Beschleunigung im Vergleich zum schleifenbasierten Ansatz!

2. LZCNT und TZCNT: Magie der führenden/nachfolgenden Nullen

Als nächstes kommen LZCNT (Leading Zero Count) und TZCNT (Trailing Zero Count). Diese Anweisungen zählen die Anzahl der führenden oder nachfolgenden Nullbits in einem Integer. Sie sind unglaublich nützlich für Operationen wie das Finden des bedeutendsten Bits, das Normalisieren von Gleitkommazahlen oder die Implementierung effizienter bitweiser Algorithmen.

Hier ist eine typische Implementierung zum Finden des bedeutendsten Bits:

int findMSB(uint32_t x) {

if (x == 0) return -1;

int position = 31;

while ((x & (1 << position)) == 0) {

position--;

}

return position;

}Nun sehen wir, wie LZCNT dies vereinfacht:

int findMSB(uint32_t x) {

return x ? 31 - __builtin_clz(x) : -1; // Wird auf unterstützten CPUs zu LZCNT kompiliert

}Auch hier sehen wir eine drastische Reduzierung der Codekomplexität und einen erheblichen Leistungszuwachs. LZCNT und TZCNT werden auf den meisten modernen CPUs in nur 3 Zyklen ausgeführt, unabhängig vom Eingabewert.

3. PDEP und PEXT: Bitmanipulation auf Steroiden

Nun sprechen wir über zwei meiner Lieblingsanweisungen: PDEP (Parallel Bits Deposit) und PEXT (Parallel Bits Extract). Diese Juwelen des BMI2 (Bit Manipulation Instruction Set 2) sind absolute Kraftpakete, wenn es um komplexe Bitmanipulationen geht.

PDEP legt Bits aus einem Quellwert in Positionen ab, die durch eine Maske angegeben sind, während PEXT Bits aus Positionen extrahiert, die durch eine Maske angegeben sind. Diese Operationen sind entscheidend in Bereichen wie Kryptographie, Kompressionsalgorithmen und sogar der Zugerzeugung in Schach-Engines!

Schauen wir uns ein praktisches Beispiel an. Angenommen, wir möchten die Bits von zwei 16-Bit-Integern in einem 32-Bit-Integer verweben:

uint32_t interleave_bits(uint16_t x, uint16_t y) {

uint32_t result = 0;

for (int i = 0; i < 16; i++) {

result |= ((x & (1 << i)) << i) | ((y & (1 << i)) << (i + 1));

}

return result;

}Nun sehen wir, wie PDEP diese Operation transformieren kann:

uint32_t interleave_bits(uint16_t x, uint16_t y) {

uint32_t mask = 0x55555555; // 0101...0101

return _pdep_u32(x, mask) | (_pdep_u32(y, mask) << 1);

}Diese auf PDEP basierende Lösung ist nicht nur prägnanter, sondern wird auch in nur wenigen Zyklen ausgeführt, verglichen mit dem schleifenbasierten Ansatz, der Dutzende von Zyklen dauern könnte.

4. MULX: Multiplikation mit einem Twist

MULX ist eine interessante Variation der Standard-Multiplikationsanweisung. Es führt eine vorzeichenlose Multiplikation von zwei 64-Bit-Integern durch und speichert das 128-Bit-Ergebnis in zwei separaten Registern, ohne irgendwelche Flags zu ändern.

Dies mag wie eine kleine Anpassung erscheinen, kann jedoch in Szenarien, in denen viele Multiplikationen durchgeführt werden müssen, ohne die Prozessor-Flags zu stören, ein Game-Changer sein. Es ist besonders nützlich in kryptographischen Algorithmen und bei der Arithmetik mit großen Zahlen.

So könnten Sie MULX in Inline-Assembly verwenden:

uint64_t high, low;

uint64_t a = 0xdeadbeefcafebabe;

uint64_t b = 0x1234567890abcdef;

asm("mulx %2, %0, %1" : "=r" (low), "=r" (high) : "r" (a), "d" (b));

// Jetzt enthält 'high' die oberen 64 Bits des Ergebnisses und 'low' die unteren 64 Bits

Die Schönheit von MULX liegt darin, dass es keine CPU-Flags beeinflusst, was eine effizientere Befehlsplanung und potenziell weniger Pipeline-Stalls in engen Schleifen ermöglicht.

Einschränkungen und Überlegungen

Bevor Sie losstürmen und Ihren Code mit diesen exotischen Anweisungen spicken, beachten Sie:

- Nicht alle CPUs unterstützen diese Anweisungen. Überprüfen Sie immer die Unterstützung zur Laufzeit oder bieten Sie alternative Implementierungen an.

- Die Unterstützung durch Compiler variiert. Möglicherweise müssen Sie Intrinsics oder Inline-Assembly verwenden, um die Verwendung bestimmter Anweisungen zu garantieren.

- Manchmal kann der Aufwand für die Überprüfung der Anweisungsunterstützung die Vorteile in kurz laufenden Programmen überwiegen.

- Der übermäßige Gebrauch spezialisierter Anweisungen kann Ihren Code weniger portabel und schwerer wartbar machen.

Zusammenfassung: Die Macht, Ihre Werkzeuge zu kennen

Wie wir gesehen haben, können seltene x86-Op-Codes in den richtigen Situationen mächtige Werkzeuge sein. Sie sind keine Allheilmittel, aber wenn sie mit Bedacht eingesetzt werden, können sie in kritischen Abschnitten Ihres Codes erhebliche Leistungssteigerungen bieten.

Die wichtigste Erkenntnis hier ist die Bedeutung, Ihre Werkzeuge zu kennen. Der x86-Befehlssatz ist umfangreich und komplex, mit regelmäßig hinzugefügten neuen Anweisungen. Informiert zu bleiben über diese Fähigkeiten kann Ihnen einen Vorteil verschaffen, wenn Sie schwierige Optimierungsprobleme angehen.

Also, das nächste Mal, wenn Sie mit einem Performance-Engpass konfrontiert sind, denken Sie daran, über das Offensichtliche hinauszuschauen. Tauchen Sie in das Befehlssatz-Referenzhandbuch Ihrer CPU ein, experimentieren Sie mit verschiedenen Op-Codes, und vielleicht finden Sie genau die Geheimwaffe, die Sie gesucht haben.

Viel Spaß beim Optimieren, liebe Bit-Tüftler!

"In der Welt des Hochleistungsrechnens ist das Wissen über Ihre Hardware genauso wichtig wie Ihre algorithmischen Fähigkeiten." - Anonymer Performance-Guru

Weiterführende Erkundung

Wenn Sie hungrig nach mehr exotischen x86-Genüssen sind, hier sind einige Ressourcen, um Ihre Reise fortzusetzen:

- x86 und amd64 Befehlssatzreferenz - Ein umfassender Leitfaden zu x86-Anweisungen

- Opcodes - Eine Datenbank von x86- und x86-64-Anweisungen

- Agner Fogs Software-Optimierungsressourcen - Detaillierte Informationen über CPU-Architektur und Optimierungstechniken

Denken Sie daran, die Reise zur Beherrschung dieser seltenen Op-Codes ist lang, aber lohnend. Experimentieren Sie weiter, führen Sie Benchmarks durch und erweitern Sie die Grenzen dessen, was mit Ihrer Hardware möglich ist. Wer weiß? Vielleicht werden Sie der nächste Optimierungszauberer in Ihrem Team!