Die üblichen Verdächtigen

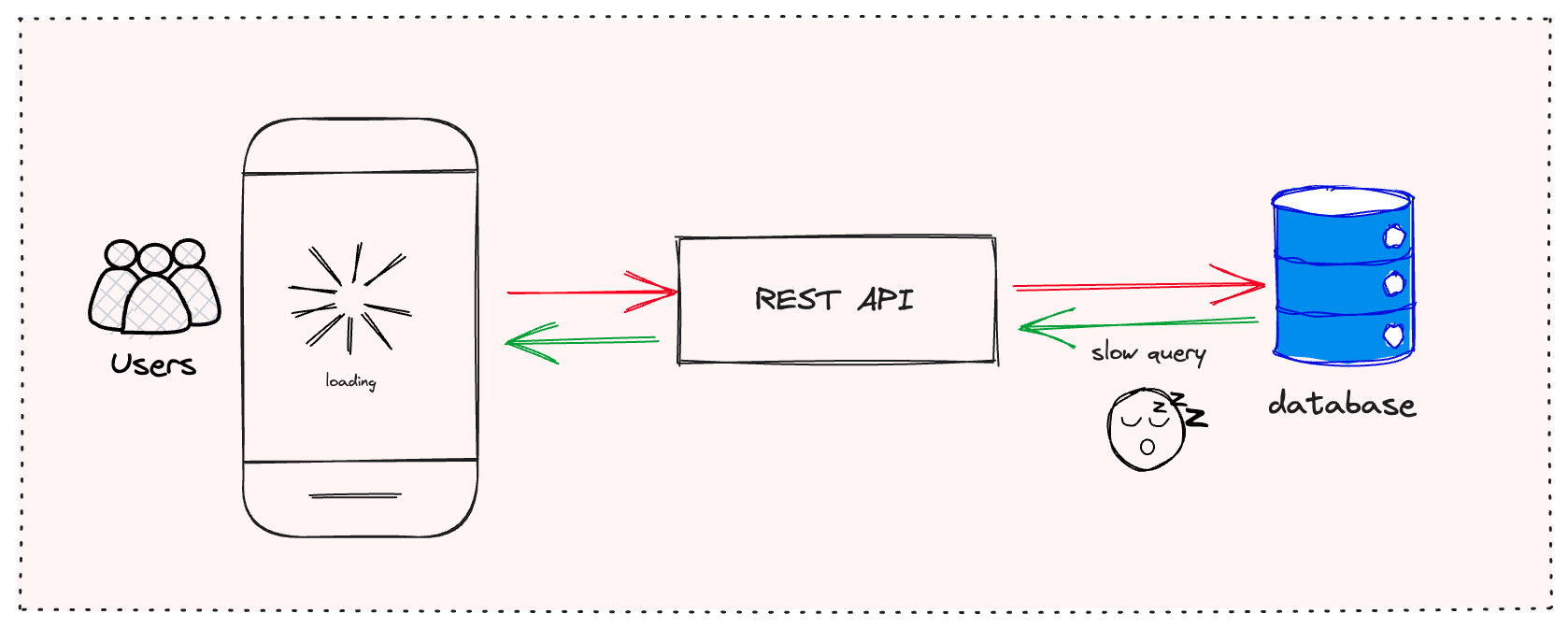

Bevor wir zu den heimlichen Übeltätern kommen, lassen Sie uns schnell die üblichen Verdächtigen durchgehen, die Sie wahrscheinlich schon in Betracht gezogen haben:

- Ineffiziente Datenbankabfragen

- Fehlendes Caching

- Unoptimierte Serverkonfigurationen

- Netzwerklatenz

Wenn Sie diese bereits angegangen sind und immer noch eine unzureichende Leistung feststellen, ist es an der Zeit, tiefer zu graben. Lassen Sie uns die versteckten Schurken aufdecken, die in den Schatten Ihrer API lauern.

1. Die Serialisierungsverzögerung

Ah, die Serialisierung. Der unbesungene Held (oder Schurke) der API-Leistung. Vielleicht denken Sie nicht zweimal darüber nach, aber das Konvertieren Ihrer Objekte in JSON und zurück kann ein erheblicher Engpass sein, besonders bei großen Datenmengen.

Das Problem:

Viele beliebte Serialisierungsbibliotheken sind zwar praktisch, aber nicht auf Geschwindigkeit optimiert. Sie verwenden oft Reflection, was langsam sein kann, besonders in Sprachen wie Java.

Die Lösung:

Erwägen Sie die Verwendung schnellerer Serialisierungsbibliotheken. Für Java kann zum Beispiel Jackson mit dem Afterburner-Modul oder DSL-JSON die Dinge erheblich beschleunigen. Hier ist ein kurzes Beispiel mit Jacksons Afterburner:

ObjectMapper mapper = new ObjectMapper();

mapper.registerModule(new AfterburnerModule());

// Verwenden Sie diesen Mapper jetzt für die Serialisierung/Deserialisierung

String json = mapper.writeValueAsString(myObject);

MyObject obj = mapper.readValue(json, MyObject.class);

Denken Sie daran, jede Millisekunde zählt, wenn Sie Tausende von Anfragen bearbeiten!

2. Der übereifrige Validator

Eingabevalidierung ist entscheidend, aber übertreiben Sie es? Zu komplexe Validierung kann schneller zu einem Leistungsalbtraum werden, als Sie "400 Bad Request" sagen können.

Das Problem:

Das Validieren jedes einzelnen Feldes mit komplexen Regeln, besonders bei großen Objekten, kann Ihre API erheblich verlangsamen. Wenn Sie zudem ein schweres Validierungsframework verwenden, könnten Sie unnötigen Overhead verursachen.

Die Lösung:

Finden Sie ein Gleichgewicht. Validieren Sie kritische Felder serverseitig, aber erwägen Sie, einige Validierungen auf den Client auszulagern. Verwenden Sie leichte Validierungsbibliotheken und erwägen Sie das Caching von Validierungsergebnissen für häufig abgerufene Daten.

Wenn Sie zum Beispiel Java's Bean Validation verwenden, können Sie die Validator-Instanz cachen:

private static final Validator validator;

static {

ValidatorFactory factory = Validation.buildDefaultValidatorFactory();

validator = factory.getValidator();

}

// Verwenden Sie diese Validator-Instanz in Ihrer gesamten Anwendung

3. Die Authentifizierungs-Lawine

Sicherheit ist unverhandelbar, aber schlecht implementierte Authentifizierung kann Ihre API in ein träges Chaos verwandeln.

Das Problem:

Jede Anfrage durch Zugriff auf die Datenbank oder einen externen Authentifizierungsdienst zu authentifizieren, kann erhebliche Latenzzeiten einführen, besonders bei hoher Last.

Die Lösung:

Implementieren Sie tokenbasierte Authentifizierung mit Caching. JSON Web Tokens (JWTs) sind eine großartige Option. Sie ermöglichen es Ihnen, die Signatur des Tokens zu überprüfen, ohne bei jeder Anfrage die Datenbank abzufragen.

Hier ist ein einfaches Beispiel mit der jjwt-Bibliothek in Java:

String jwtToken = Jwts.builder()

.setSubject(username)

.signWith(SignatureAlgorithm.HS256, secretKey)

.compact();

// Später zur Überprüfung:

Jws claims = Jwts.parser()

.setSigningKey(secretKey)

.parseClaimsJws(jwtToken);

String username = claims.getBody().getSubject();

4. Das gesprächige API-Syndrom

Ist Ihre API gesprächiger als ein Podcast-Moderator? Übermäßige HTTP-Anfragen können ein großer Leistungskiller sein.

Das Problem:

APIs, die mehrere Roundtrips benötigen, um eine einzelne logische Operation abzuschließen, können unter erhöhter Latenz und verringerter Durchsatzrate leiden.

Die Lösung:

Nutzen Sie Batching und Massenoperationen. Anstatt für jedes Element separate Anfragen zu stellen, erlauben Sie es den Clients, mehrere Elemente in einer einzigen Anfrage zu senden. GraphQL kann hier ebenfalls ein Game-Changer sein, da es den Clients ermöglicht, genau das anzufordern, was sie in einer einzigen Abfrage benötigen.

Wenn Sie Spring Boot verwenden, können Sie einfach einen Batch-Endpunkt implementieren:

@PostMapping("/users/batch")

public List createUsers(@RequestBody List users) {

return userService.createUsers(users);

}

5. Der aufgeblähte Antwort-Blob

Tragen Ihre API-Antworten mehr Gewicht als ein Sumoringer? Übermäßig ausführliche Antworten können Ihre API verlangsamen und die Bandbreitennutzung erhöhen.

Das Problem:

Mehr Daten zurückzugeben, als notwendig ist, einschließlich Feldern, die vom Client nicht verwendet werden, kann die Antwortgröße und die Verarbeitungszeit erheblich erhöhen.

Die Lösung:

Implementieren Sie Antwortfilterung und Paginierung. Erlauben Sie den Clients, anzugeben, welche Felder zurückgegeben werden sollen. Verwenden Sie für Sammlungen immer die Paginierung, um die Menge der in einer einzigen Antwort gesendeten Daten zu begrenzen.

Hier ist ein Beispiel, wie Sie die Feldfilterung in Spring Boot implementieren könnten:

@GetMapping("/users")

public List getUsers(@RequestParam(required = false) String fields) {

List users = userService.getAllUsers();

if (fields != null) {

ObjectMapper mapper = new ObjectMapper();

SimpleFilterProvider filterProvider = new SimpleFilterProvider();

filterProvider.addFilter("userFilter", SimpleBeanPropertyFilter.filterOutAllExcept(fields.split(",")));

mapper.setFilterProvider(filterProvider);

return mapper.convertValue(users, new TypeReference>() {});

}

return users;

}

6. Das Klagelied des eifrigen Ladens

Laden Sie Daten, als ob Sie sich auf eine Datenapokalypse vorbereiten? Übermäßiges Laden von Daten kann ein stiller Leistungskiller sein.

Das Problem:

Das Laden aller zugehörigen Entitäten für ein Objekt, auch wenn sie nicht benötigt werden, kann zu unnötigen Datenbankabfragen und erhöhten Antwortzeiten führen.

Die Lösung:

Implementieren Sie Lazy Loading und verwenden Sie Projektionen. Holen Sie sich nur die Daten, die Sie benötigen, wenn Sie sie benötigen. Viele ORMs unterstützen Lazy Loading von Haus aus, aber Sie müssen es klug einsetzen.

Wenn Sie Spring Data JPA verwenden, können Sie Projektionen erstellen, um nur die erforderlichen Felder abzurufen:

public interface UserSummary {

Long getId();

String getName();

String getEmail();

}

@Repository

public interface UserRepository extends JpaRepository {

List findAllProjectedBy();

}

7. Die unbedachte Caching-Strategie

Sie haben Caching implementiert, klopfen Sie sich auf die Schulter! Aber Moment, cachen Sie intelligent oder einfach alles, was Ihnen in den Weg kommt?

Das Problem:

Caching ohne eine richtige Strategie kann zu veralteten Daten, unnötiger Speichernutzung und sogar zu langsamerer Leistung führen, wenn es nicht richtig gemacht wird.

Die Lösung:

Implementieren Sie eine intelligente Caching-Strategie. Cachen Sie häufig abgerufene, selten geänderte Daten. Verwenden Sie Cache-Ablaufrichtlinien und erwägen Sie die Verwendung eines verteilten Caches für Skalierbarkeit.

Hier ist ein Beispiel mit Spring's Caching-Abstraktion:

@Cacheable(value = "users", key = "#id", unless = "#result == null")

public User getUserById(Long id) {

return userRepository.findById(id).orElse(null);

}

@CacheEvict(value = "users", key = "#user.id")

public void updateUser(User user) {

userRepository.save(user);

}

Die Quintessenz

Leistungsoptimierung ist ein fortlaufender Prozess, keine einmalige Aufgabe. Diese versteckten Killer können sich im Laufe der Zeit in Ihre API einschleichen, daher ist es wichtig, regelmäßig das Profil zu erstellen und die Leistung Ihrer API zu überwachen.

Denken Sie daran, der schnellste Code ist oft der, der überhaupt nicht ausgeführt wird. Fragen Sie sich immer, ob Sie eine Operation durchführen, ein Datenstück abrufen oder ein Feld in Ihre Antwort aufnehmen müssen.

Indem Sie diese versteckten Leistungskiller angehen, können Sie Ihre träge API in eine schlanke, effiziente Anfragenverarbeitungsmaschine verwandeln. Ihre Benutzer (und Ihr Ops-Team) werden es Ihnen danken!

"Vorzeitige Optimierung ist die Wurzel allen Übels." - Donald Knuth

Aber wenn es um APIs geht, ist rechtzeitige Optimierung der Schlüssel zum Erfolg. Also gehen Sie voran, profilieren Sie Ihre API, und mögen Ihre Antwortzeiten immer zu Ihren Gunsten sein!

Denkanstöße

Bevor Sie sich daran machen, Ihre API zu optimieren, nehmen Sie sich einen Moment Zeit zum Nachdenken:

- Messen Sie die richtigen Metriken? Die Antwortzeit ist wichtig, aber berücksichtigen Sie auch Durchsatz, Fehlerraten und Ressourcennutzung.

- Haben Sie die Kompromisse bedacht? Manchmal kann die Optimierung für Geschwindigkeit auf Kosten der Lesbarkeit oder Wartbarkeit gehen. Ist es das wert?

- Optimieren Sie für die richtigen Anwendungsfälle? Stellen Sie sicher, dass Sie sich auf die Endpunkte und Operationen konzentrieren, die für Ihre Benutzer am wichtigsten sind.

Denken Sie daran, das Ziel ist nicht nur eine schnelle API, sondern eine API, die Ihren Benutzern effizient und zuverlässig Mehrwert bietet. Jetzt machen Sie Ihre API flott!